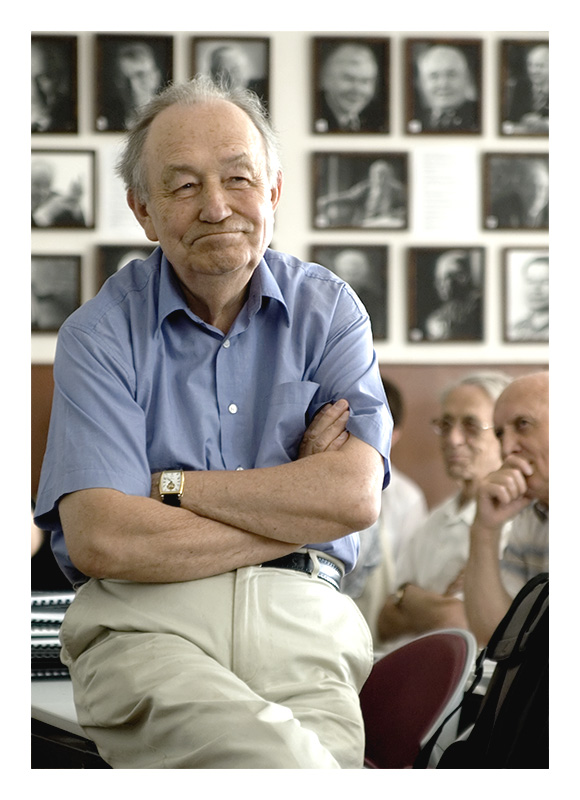

14 января ушёл из жизни мой учитель, глава большой научной школы академик Юрий Иванович Журавлёв. Это пост памяти о нём – о том, чему я научился у Юрия Ивановича и за что ему благодарен. В конце – ссылки на интервью и видео.

Читать далееАвтор: alexanderdyakonov

Графовые нейронные сети

Мы расскажем про популярный класс нейронных сетей – графовые сети. Манера повествования позволит понять, как они устроены, даже новичкам в машинном обучении, однако обзор видов сетей и конструкций в них представлен достаточно полный, с использованием специальных терминов. Прямо сейчас есть несколько отличных источников по графовым сетям (см. ссылки в конце), однако этот материал у меня давно лежал (нет, правда, красивых картинок) и перед новым годом появилось время сделать заметку, поэтому я решил его опубликовать.

Эссе по курсу «Глубокое обучение»

Для тех, кто больше любит читать, чем смотреть и слушать, немного материалов по глубокому обучению…

Читать далееРабота DS: зарплаты, занятость и желания

Подводим итоги опроса по работе аналитиков данных, который ранее запускали на телеграм-канале. Спасибо всем, кто принял участие! Было желание опросить 1000 человек, к тому же в предварительном опросе приняло участие гораздо больше, но заполнить гугл-форму для многих оказалось чуть сложнее, чем пройти один опрос в телеграме. Всё равно, получился один из самых больших опросов в сфере Data Science.

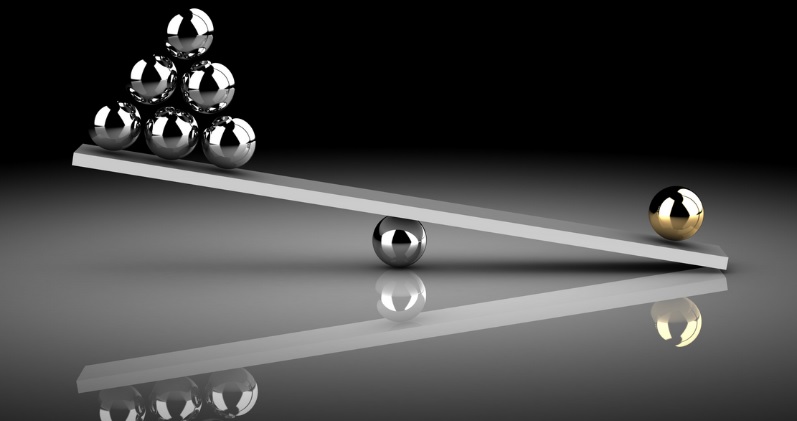

Дисбаланс классов

Рассмотрим ситуацию несбалансированных классов – что нужно уточнить при выработке стратегии решения задачи классификации, какие стратегии бывают, как отвечать на вопрос про дисбаланс на собеседовании. Приведём результаты экспериментов, дадим код и практические советы. Уровень для читателя — средний (достаточно знать основы машинного обучения и иметь небольшой опыт в решении задач классификации).

Scikit-Learn: тонкие вопросы о реализации методов машинного обучения

Рассмотрим несколько с виду простых вопросов об алгоритмах машинного обучения и их реализации, на которые, однако, немногие смогут верно ответить (можете попробовать сами – не читая объяснений, также в посте приведены дополнительные вопросы специально оставленные без ответа). Материал для среднего уровня (тех, кто уже знает ML и библиотеку sklearn).

Читать далеекурс «Прикладные задачи анализа данных»

На сайте появилась новая вкладка «Курсы», а главное, выложены материалы этого года (слайды и видео) курса ПЗАД, который читается для студентов ВМК МГУ, а ниже немного об истории курса.

Скоринговые ошибки (Proper Scoring Rules)

Продолжаем рассказывать про функции ошибки и функционалы качества, сегодня поговорим о функциях, которые «заставляют» алгоритм выдавать вероятности принадлежности к классам. Рассчитано на читателей, которые освоили предыдущие посты по этой теме.

Читать далееАугментация для текстов (Text Augmentation)

Похоже, на русском языке нет полного обзора по современным методам аугментации при работе с текстами, поэтому появился этот… На английском языке есть несколько очень хороших, но здесь удалось осветить более свежие научные работы. Целевая аудитория обзора — начинающие в NLP.

Дистилляция данных (Data Distillation)

Расскажем об одном DL-подходе к задаче сокращения размера выборки, а на самом деле, даже более амбициозной задаче — создания синтетических данных, хранящих всю полезную информацию о выборке.

Читать далее